Google Voice Search

Google е един от пионерите в изследванията на изкуствения интелект и множество техни проекти продължават да въртят главите си. AlphaZero от Google DeepMind Екипът беше пробив в изследванията на ИИ, поради способността на програмата да научи сложни игри от само себе си (без човешко обучение и намеса). Google също свърши отлична работа в Програми за обработка на естествен език (NLP), което е една от причините за ефективността на Google Assistant при разбирането и обработката на човешката реч.

Google наскоро обяви пускането на три нови ИЗПОЛЗВАЙТЕ многоезични модули и предоставят повече многоезични модели за извличане на семантично подобен текст.

Първите два модула предоставят многоезични модели за извличане на семантично подобен текст, единият оптимизиран за производителност на извличане, а другият за скорост и по-малко използване на паметта. Третият модел е специализиран за извличане на въпрос-отговор на шестнадесет езика (USE-QA) и представлява изцяло ново приложение на USE. И трите многоезични модула са обучени с помощта на многозадачна рамка с двоен кодер , подобно на оригиналния USE модел за английски, докато използвахме техники, които разработихме за подобряване на двоен кодер с подход на добавка марж softmax . Те са предназначени не само за поддържане на добри резултати от обучението по трансфер, но и за изпълнение на n n семантични задачи за извличане.

Езиковата обработка в системите е изминала дълъг път, от разбор на основното синтаксисно дърво до големи векторни модели на асоцииране. Разбирането на контекста в текста е един от най-големите проблеми в полето на НЛП и Universal Sentence Encoder решава това чрез преобразуване на текст във високоразмерни вектори, което улеснява класирането и денотирането на текста.

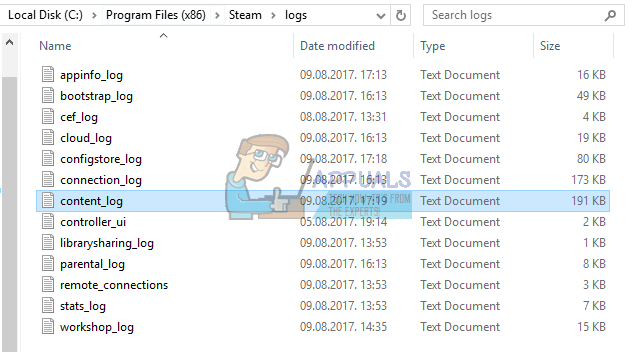

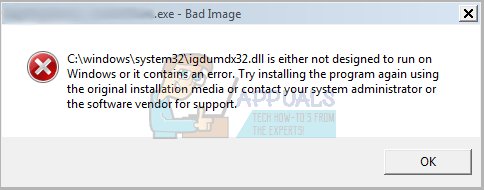

Източник на структурата за маркиране на UTE - блог на Google

Според Google „ Всичките три нови модула са изградени върху семантична архитектура за извличане, която обикновено разделя кодирането на въпроси и отговори на отделни невронни мрежи, което дава възможност за търсене сред милиарди потенциални отговори в рамките на милисекунди. С други думи, това помага за по-доброто индексиране на данните.

' И трите многоезични модула са обучени с помощта на многозадачна рамка с двоен кодер , подобно на оригиналния USE модел за английски, докато използвахме техники, които разработихме за подобряване на двоен кодер с подход на добавка марж softmax . Те са предназначени не само за поддържане на добри резултати от обучението по трансфер, но и за изпълнение на n n семантични задачи за извличане . ' Функцията Softmax често се използва за спестяване на изчислителна мощност чрез степенуване на вектори и след това разделяне на всеки елемент на сумата от експоненциалното.

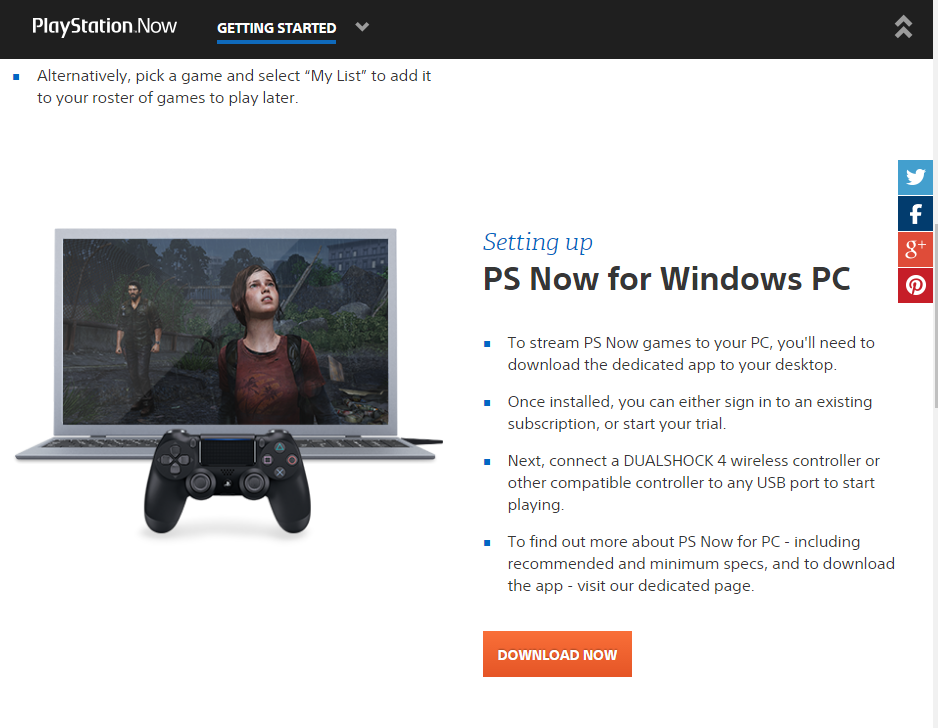

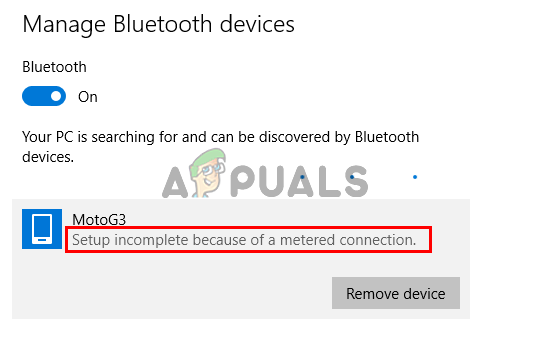

Семантична архитектура за извличане

„Трите нови модула са изградени върху семантични архитектури за извличане, които обикновено разделят кодирането на въпроси и отговори в отделни невронни мрежи, което дава възможност за търсене сред милиарди потенциални отговори в рамките на милисекунди. Ключът към използването на двойни кодери за ефективно семантично извличане е да се кодират предварително всички кандидат-отговори на очакваните входни заявки и да се съхраняват във векторна база данни, която е оптимизирана за решаване на проблем с най-близкия съсед , което позволява голям брой кандидати да бъдат търсени бързо с добро прецизност и изземване . '

Можете да изтеглите тези модули от TensorFlow Hub. За по-нататъшно четене вижте пълния текст на GoogleAI блог пост .

Етикети google

![[FIX] Бяла лента, покриваща горната част на Windows Explorer](https://jf-balio.pt/img/how-tos/17/white-bar-covering-top-portion-windows-explorer.jpg)